AI音源技術

VOCALOID:AI®,AI楽器音合成技術

AI音源技術とは

音源技術とは、楽器や歌声など音楽を構成する「音」そのものを作りだす(合成する)技術のことです。たとえば、電子ピアノやシンセサイザーなどで、本物のアコースティック楽器そっくりのリアルな音から電子楽器ならではの個性的な音まで、様々な音を作りだしているのはこの技術です。そこに人工知能(AI)技術を導入して進化させた、音色だけでなく演奏のニュアンスまで含めてまるで本当に人間が演奏しているかのような音を作りだすものが、このAI音源技術です。 ヤマハのAI音源技術として初めて開発されたのが2019年に発表したAI歌声合成技術「VOCALOID:AI®」です。その後、さらにそれを楽器音に応用して新たに開発したAI楽器音合成技術を、2021年に発表しています。

VOCALOID:AI®(AI歌声合成技術)

VOCALOID はヤマハが長年研究開発を積み重ねてきた独自の歌声合成技術です。「音符と歌詞を入力するとその通り歌ってくれる」この技術は、同名の音楽制作ソフトに搭載され、最新のVOCALOID6に至るまで広く音楽制作のシーンで利用されています。特にその中でAI技術を使用し進化させた新技術がVOCALOID:AI®です。

VOCALOID:AI® は「音源自ら表現する」まったく新しいボーカル音源です。ユーザーから音符と歌詞が与えられると、ただそれをなぞるだけでなく、音源自身が自らそこに乗せるニュアンス(たとえば音色の選び方や音のつなぎ方、ビブラートのかけ具合など)を判断し、まるで本当の人のような生き生きとした歌声を作りだします。 これが従来の音源技術と決定的に異なるのは、音源側独自の判断により、ときにクリエイターが思いもよらないような歌唱表現を作りだしてくるというところです。クリエイターはこれにインスピレーションを受け新たな創作につなげるなど、AIとの共同作業によって作品を作りだしていくことができます。クリエイターと音源のこのような関係は、人と道具の関係というよりも、ディレクターと歌手の関係に近いものと言えるでしょう。

VOCALOID:AI®が行う処理は大きく分けて学習フェーズと合成フェーズから成ります。

基本的な学習の仕組み

学習フェーズでは、VOCALOID:AI®は与えられた人間の歌手の歌声に含まれる音色や歌いまわしなどの特徴を、深層学習(ディープラーニング)技術により学習します。その結果、歌手ごとの歌唱表現や癖を含んだ歌声を、どんなメロディと歌詞からでも作り出すことが可能になります。

具体的にはまず、「音色」「ピッチ(音高)」を歌声から、「楽譜とのタイミングずれ」を歌声と楽譜のペアデータから、それぞれ数値として抽出します(これらの要素を特徴量と呼びます)。学習フェーズの狙いは、AIに「このような音符の並び・歌詞のときはこのような特徴量が現れる傾向がある」と学ばせることです。しかし人間の歌声の中には、音符の並びと歌詞だけでは決まらない要素もあります。たとえばまったく同じメロディと歌詞であっても、曲自体の雰囲気やジャンルごとに、あるいは弱く歌うか強く歌うかによって、声の音色は違ったものになります。そこで、実際の歌声から抽出した強弱の数値と、歌われた曲が何であるかの情報(曲ID)もあわせてAIに与えます。これによって、音符・歌詞だけでは説明できないような歌唱スタイルのバリエーションも含めた学習を可能にしています。

この学習フェーズは数時間~数日といった時間をかけてコンピューターが計算を繰り返すことで行われます。

VOCALOID:AI®は、続く合成フェーズにおいて2つの大きな特徴を持ちます。

特徴1:AI歌手への歌唱表現のリクエスト

VOCALOID:AI®は与えられた音符・歌詞に対して自動的に歌唱ニュアンスをつけますが、それが必ずしもユーザー側が求める音楽表現とマッチするとは限りません。AI音源をあくまで人間の音楽表現のための存在と捉えたとき、そこに「人の意図」を乗せられることが非常に重要になります。

VOCALOID:AI®ではユーザーが音符と歌詞以外に、音楽表現に関するリクエストを伝えることができます。ここで、学習フェーズで導入した曲IDの情報と強弱値の情報が使用されます。学習時に使用した曲IDの指定により「○○という曲の雰囲気で」、強弱表現の数値指定により「やや力強いニュアンスで」のような形の表現リクエストができます。それを受けたVOCALOID:AI®は、学習元のシンガーならそのリクエストに対してどのように歌うかを推定し、音のつなぎ方やビブラート、喉の開き具合、息の混ぜ具合までも含めて、複雑かつ音楽的に音を変化させます。これによりユーザーは、まるでディレクターが歌手に口頭で指示を出すようなシンプルさでボーカルトラックを作りだすことができるのです。

特徴2:演奏中のAI歌手とのリアルタイムなインタラクション

VOCALOID:AI®では前述の歌唱表現のリクエスト操作を、合成音を生成している最中にリアルタイムに行うことができます。この、あたかもバーチャルシンガーとインタラクティブなかけあいを楽しむように音楽を作れる機能は、ヤマハのAI合成技術ならではの特に重要なポイントです。

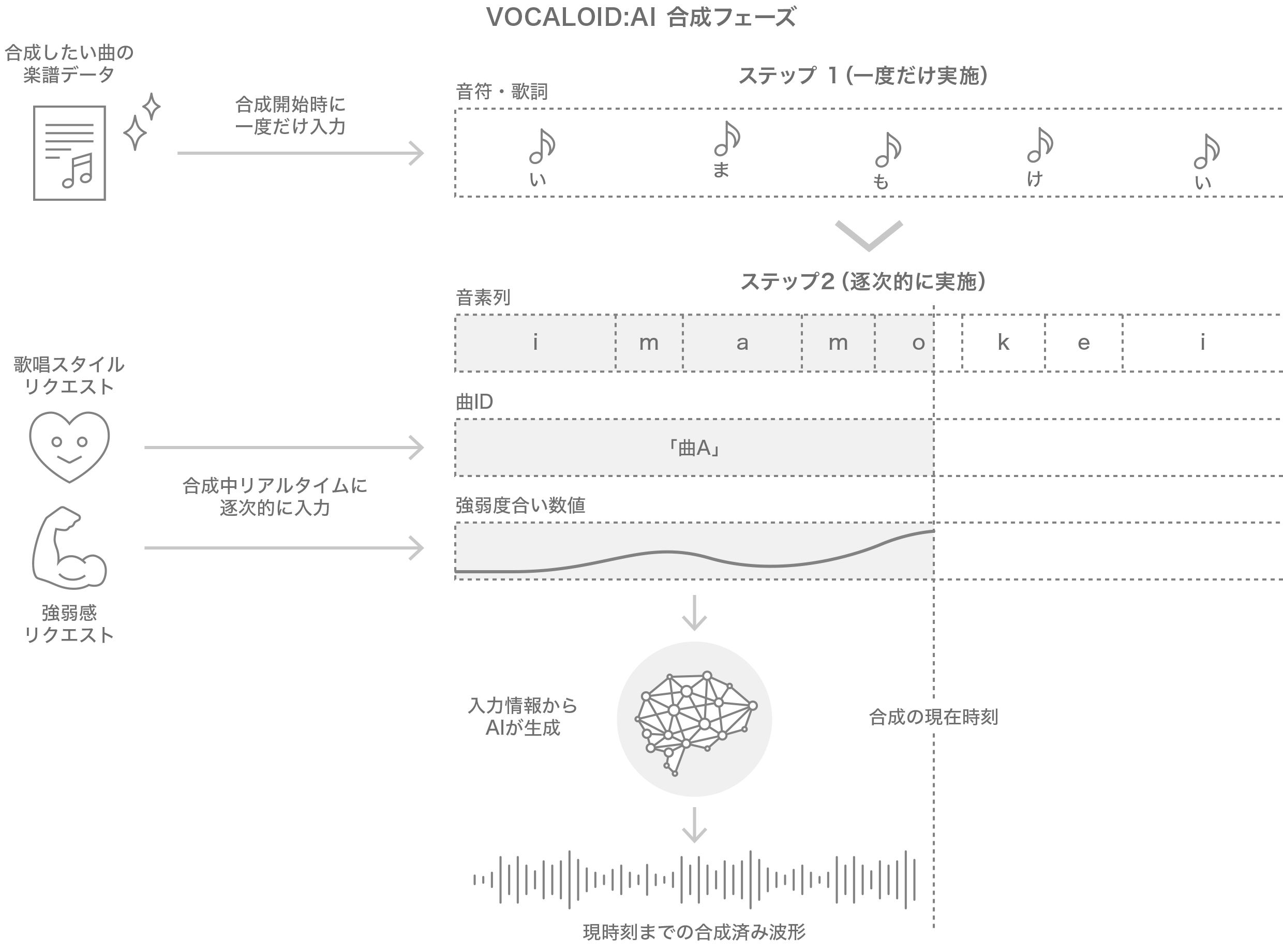

合成フェーズは大きく2つのステップに分かれます。まずステップ1では楽譜全体の情報がまとめて入力されます。これにより曲全体の構成がどうなっているか、各音符はどういう音符と接続しているか…などの情報をAIが把握できます。続くステップ2は時々刻々と(例えば1秒間に100回など)行われる処理で、曲IDや強弱度合い数値の指定を受けて、その瞬間にどういう音を出すかを決定します。これらを人の歌唱に置き換えると、ステップ1は楽譜を読んで解釈・理解するところ、ステップ2は実際に歌を歌うところに相当します。

AI楽器音合成技術

私たちはVOCALOID:AI®の技術を、歌声だけでなく広く楽器音へ応用したAI楽器音合成技術を開発しました。現在のところ、歌声とほぼ同様の仕組みでサクソフォン、トランペット、フルート、クラリネット、オーボエなど管楽器の生き生きとした演奏を、AI技術によって実現することが可能になっています。

こちらも、「音源自ら表現する」まったく新しい楽器音源と言えます。楽譜が与えられると、その音符の並びを見て音源自身が表現のニュアンスを自ら判断して、ビブラートやクレッシェンド・デクレシェンドなども含めた楽器の演奏音(波形)を作りだします。このため、ユーザーが難しい表現パラメータを詳細に与えるよりもずっとシンプルな操作で本格的な管楽器の演奏トラックが作りだせます。

AI楽器音合成技術もまた、VOCALOID:AI®と同じ2つの特徴を持ち合わせています。

特徴1:AI奏者への演奏表現のリクエスト

「(学習データ内の)○○という曲の雰囲気で」や「やや力強いニュアンスで」といったリクエストを与えると、AIがそのリクエストを踏まえ、学習元の演奏者だったらこのように演奏するだろうという推定を行い、波形を生成します。学習のさせ方次第では、「〇〇という曲の雰囲気」の代わりに「ボサノバっぽく」「ファンクっぽく」のようなジャンルレベルの指定も可能になります(これはVOCALOID:AI®でも同様です)。

特徴2:演奏中のAI奏者とのリアルタイムなインタラクション

あらかじめ曲全体の楽譜を読み込ませた上で、合成処理を行っている最中にリアルタイムに演奏表現のリクエストを入力することができます。

これらの特徴を持つAI音源技術は、仮想的なAI演奏者に楽器を演奏してもらうような意味合いが強いものです。そのため、従来型シンセサイザーのようにリアルタイムに鍵盤を弾くことでユーザーが演奏を行うような使い方というよりは、仮想的なAI演奏者とユーザーが相互に働きかけながら音楽を作り出していくような使い方に強みがあります。例えば、人間の楽器演奏とAI演奏者でセッションするような場面や、DTMによる音楽制作の場面などでは特にその強みを発揮するでしょう。

応用事例

AI Artist Stage

静岡県浜松市のヤマハ本社内の企業ミュージアム「イノベーションロード」にて、VOCALOID:AI®およびAI楽器音合成技術を体感できる展示「AI Artist Stage AIとともに音楽をつくる」が2021年6月から公開されています。ここでは来場者はAIシンガーもしくはAIサクソフォン奏者のどちらかのAIアーティストを選択して、専用の「演奏表現センサー」を通して彼らの演奏の盛り上がり度合いをリアルタイムに指定することで、AIとともに1曲を演奏する体験ができます。

「AIでよみがえる美空ひばり」プロジェクト

故人であり稀代の名歌手である美空ひばりさんにもう一度会いたいと願うファンの想いを、最新の技術で実現するというプロジェクトが日本放送協会(NHK)主導のもとで立ち上がりました。その中で秋元康さんがプロデュースする新曲「あれから」の歌声合成による表現にVOCALOID:AI®が用いられました。レコード会社に残る美空ひばりさんの過去の歌声から学習を行い、秋元康さんのプロデュース意図によるリクエストに応えた「あれから」の歌声が、約200名の往年のファンを集めたコンサートで披露されました。その様子は2019年9月29日にドキュメンタリー番組「NHKスペシャル」で放映され、大きな反響を呼びました。